CodePlan:赋予大模型结构化思维,解锁推理潜能

AIxiv专栏持续报道全球顶尖AI研究成果。本文介绍清华大学和蚂蚁技术研究院的研究团队在ICLR 2025上提出的CodePlan框架,该框架通过引入代码形式的规划,显著提升了大模型的推理能力。

大模型推理的瓶颈:思维熵增

尽管大模型推理能力飞速发展,但一个被忽视的问题是“思维熵增”:模型推理过程冗长、缺乏焦点,即使是简单问题也产生过长的推理链。 这源于自然语言的非结构化特性与系统化推理需求之间的矛盾。现有方法依赖于自然语言随机探索和强化学习筛选,效率低下且难以沉淀可复用的知识。

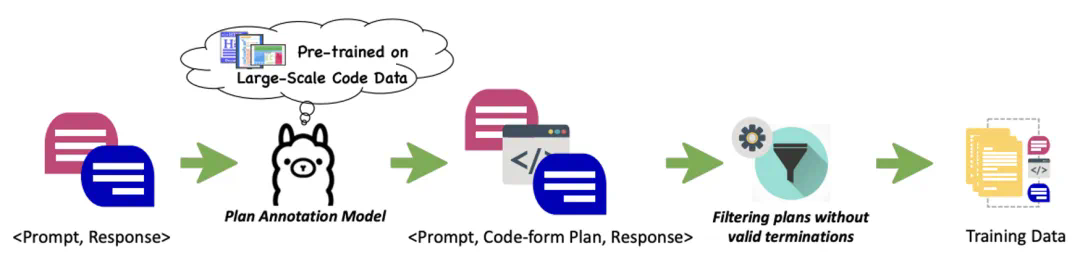

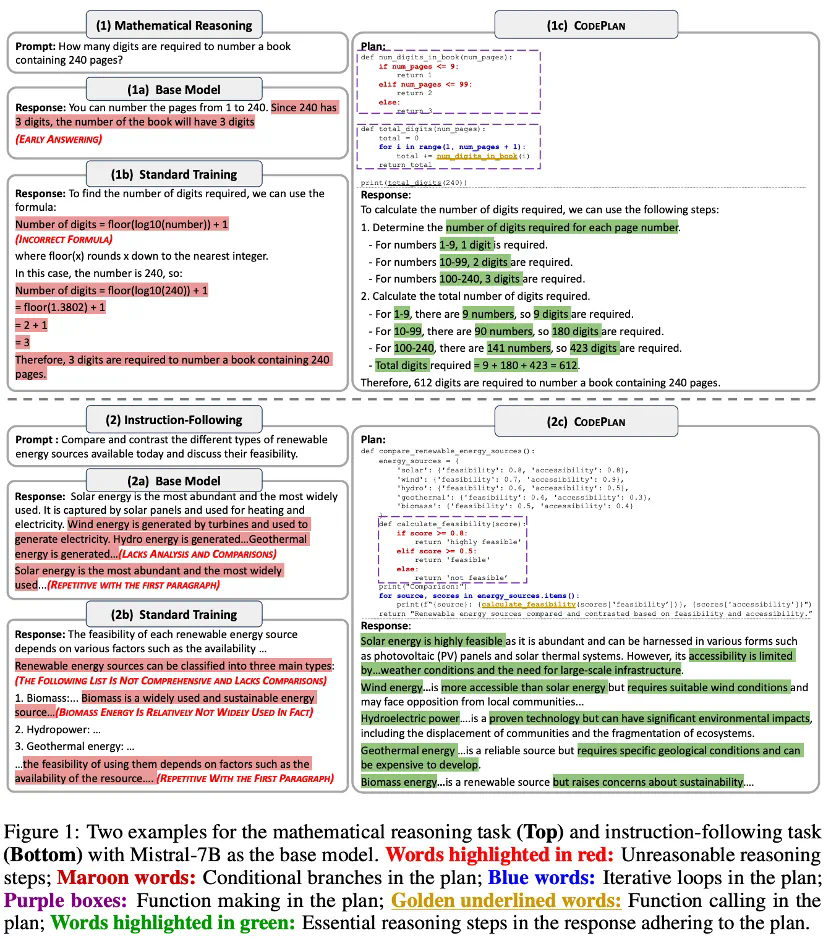

CodePlan:代码规划引领结构化思维

CodePlan框架的核心创新在于使用“代码形式规划”作为思维的中间表征。 它利用编程语言的严谨性,为大模型构建了一个“思维操作系统”,包含条件分支、循环迭代、函数调用等结构化元素。 这种方法具有以下优势:

- 精确表达: 代码精准地表达推理结构,避免自然语言的模糊性。

- 高效学习: 代码在预训练数据中广泛存在,降低了模型学习成本。

- 通用性强: 适用于各种推理任务,包括数学、符号运算、指令理解等。

- 自动挖掘: 无需大量人工标注,可自动从现有数据中提取规划信号。

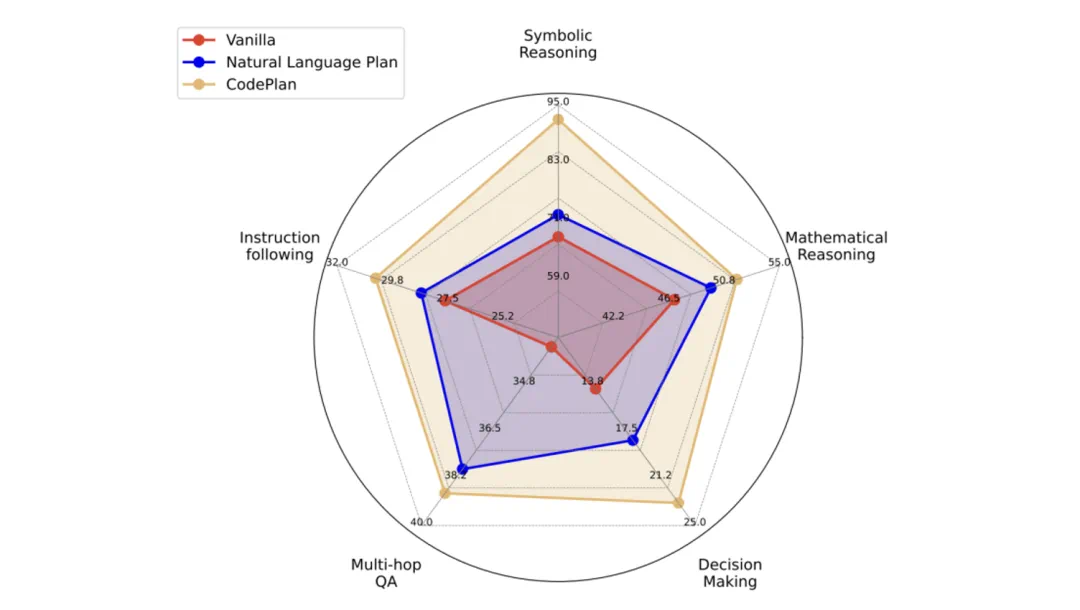

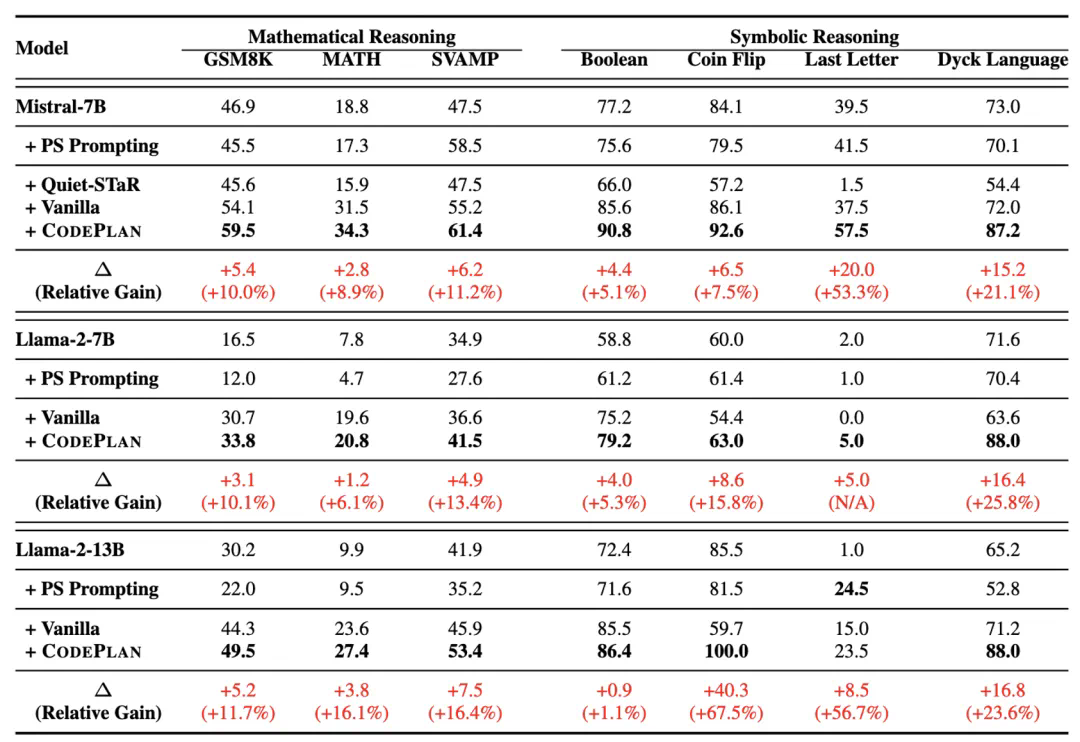

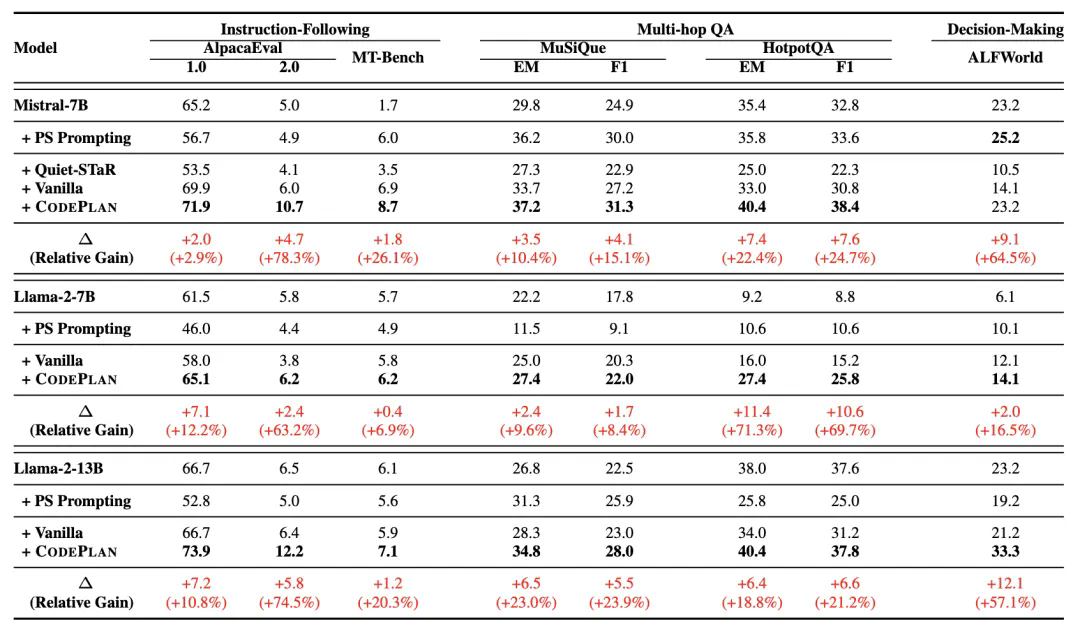

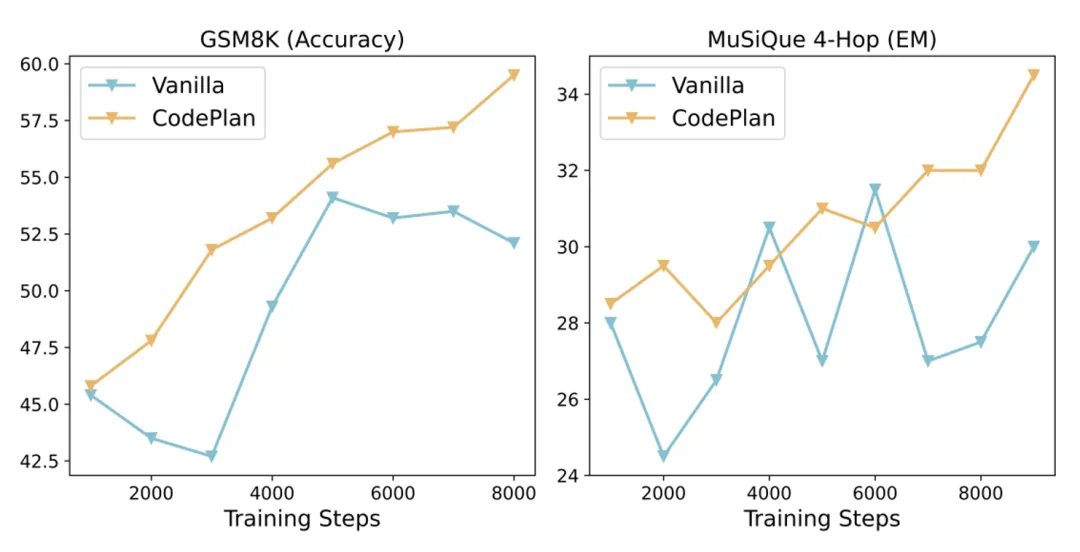

显著的性能提升与高效训练

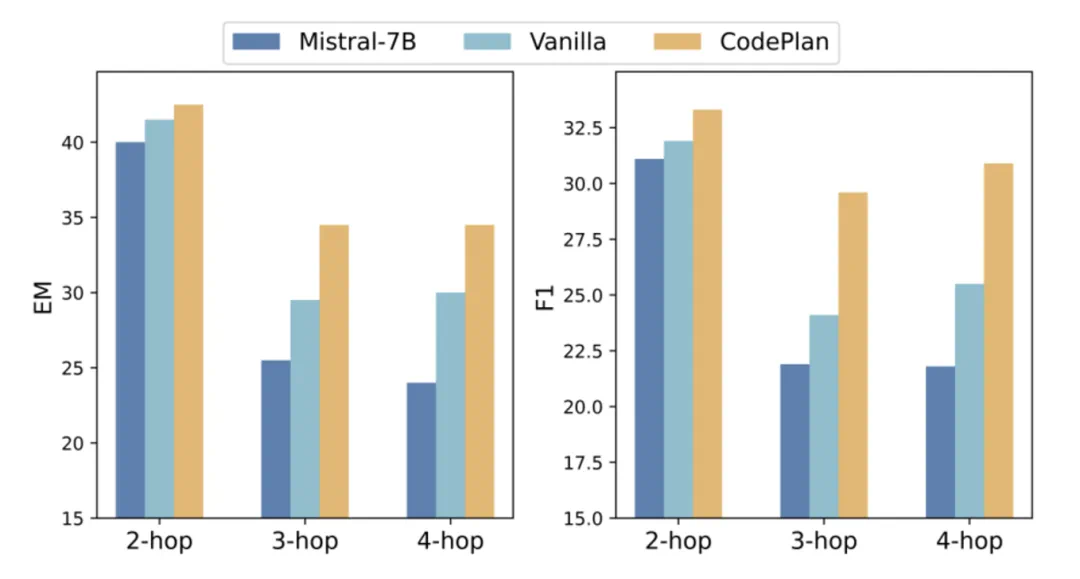

CodePlan在13个基准测试中平均提升了25.1%的性能,尤其在复杂任务中优势更加明显。 它还展现出高效稳定的后训练特性,训练曲线平稳上升,避免了传统方法的性能波动。

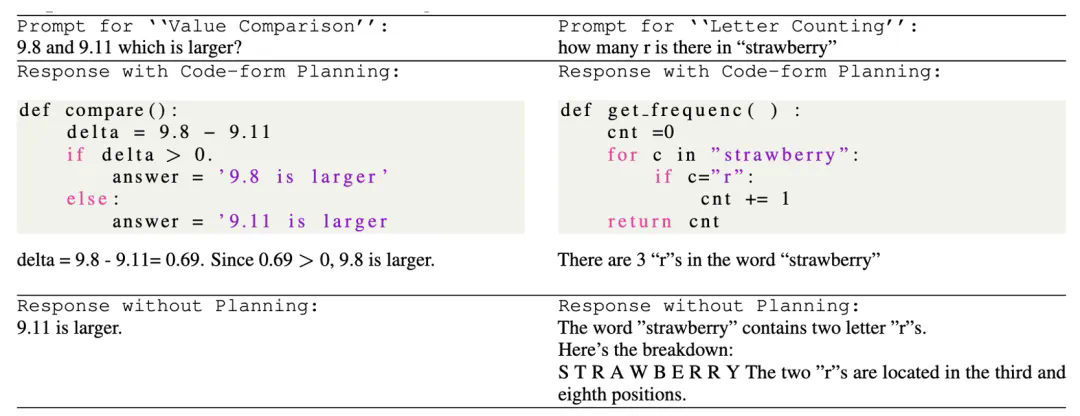

案例分析:化繁为简

CodePlan通过代码规划,有效解决了传统方法在数值比较和字母计数等简单任务中出现的模糊或错误答案问题,展现了其化繁为简的结构化思维能力。

总结:开创大模型推理新篇章

CodePlan为大模型推理能力的提升提供了新的方向。通过开源200万条规划数据,该研究为社区贡献了宝贵的资源,并有望在更多领域取得突破性进展。

- 论文标题: CodePlan: Unlocking Reasoning Potential in Large Language Models by Scaling Code-form Planning

- 论文地址: https://www.php.cn/link/ba01738f996a524bd59e9a05c929ac06

- Github: https://www.php.cn/link/ba01738f996a524bd59e9a05c929ac06

- Dataset: https://www.php.cn/link/ba01738f996a524bd59e9a05c929ac06